Es el futuro de los videojuegos, pero nunca había estado tan cerca

52 COMENTARIOS

Hace algún tiempo se me ocurrió que estaría bien hablar del futuro. Del futuro cercano que quizá podríamos experimentar en los videojuegos, claro. Y hoy es el momento adecuado para empezar a soñar con lo que se nos podría venir encima.

¿Qué camino podría seguir la industria del videojuego en los próximos años? Está claro que con la potencia gráfica que va a tener la próxima generación de consolas (una potencia que ya está disponible en muchos PC's de gama media-alta, por cierto) estamos encaminados a obtener gráficos cada vez más realistas. Pero, ¿es una cuestión de presentar personajes que cada vez estén hechos de más polígonos?

No es una cuestión (sólo) de polígonos

Alvy Ray Smith, fundador de pixar y uno de los pioneros en esto de mostrar gráficos 3D por ordenador, se la jugó al afirmar que "la realidad llegaría cuando alcanzásemos los 80 millones de polígonos por fotograma".

Esa afirmación tenía sentido en los ochenta y en los noventa cuando el principal cuello de botella para las tarjetas gráficas pasaba por la capacidad de gestionar decenas o centenas de polígonos texturizados en tiempo real. ¿Recordáis cómo se veían los juegos en 3D del año 1997 por poner un ejemplo?

Un personaje del mítico 'Half-Life' podría estar formado por 300 o 400 polígonos, a Manny Calavera de 'Grim Fandango' lo componían tan sólo 250. La industria del entretenimiento 3D, como aquel que dice, estaba todavía acelerando y rompiendo barreras a gran velocidad hasta llegar a un punto en el que la gestión de polígonos texturizados por segundo ya no fuese el gran bloque de cemento que bloqueaba la carretera.

A día de hoy una Xbox 360 o una PlayStation 3 pueden enfrentarse sin problemas a un personaje principal de 30.000 polígonos como es el caso de Nathan en 'Uncharted 3' o de 25.000 como es el caso de Marcus Fénix en 'Gears of War 3'. Se espera que la próxima generación de consolas ni se despeine con modelos que pasen del millón de polígonos.

¿Y qué me decís de un iPhone? El iPhone 4 de Apple puede encargarse de unos 20.000 polígonos texturizados por fotograma (siempre que controlemos las llamadas a pintado, aunque esa es otra historia) y estamos hablando de un hardware de hace ya dos años y medio. Imaginad lo que un Nexus 4, un Samsung Galaxy SIII o un iPhone 5 pueden mover.

Pero ahora sabemos que la cantidad de polígonos ya no es un problema y que los lanzamisiles de esta batalla deben apuntar a otros lugares: la representación y fidelidad de la textura mediante shaders avanzados, la iluminación, la animación, la física en tiempo real a gran escala y también a la inmersión en el juego, algo por lo que apuestan pesos pesados como Gabe Newell, John Carmack o Cliff Bleszinski.

La simulación física a gran escala

Los magos lo hacen muy bien. Captan tu mirada en un punto de su show, con un movimiento estudiado, con un chiste, con una palmada… en definitiva, reclaman tu atención desviándola de donde realmente debería estar para que no veas el truco que están realizando.

Crees estar viendo el cuadro entero aunque en realidad estás pendiente sólo de una parte. Durante muchos años la simulación física en un videojuego podría resumirse de una forma semejante. No todo tiene simulación física real en un videojuego, no todo el mundo 3D responde a las leyes de la gravedad, el rebote, la fricción… sólo aquello que es importante para el jugador.

En 'Half-Life 2' fuimos conscientes de la potencia de aquellos puzzles de físicas, de aquel dispositivo que podía levantar cosas y arrojarlas de un modo realista. Pero de nuevo, no podía mover todo, ni todo se comportaba de un modo acorde a la realidad. Pero ya habíamos empezado a andar por el camino correcto.

Años más tarde nos encontramos con juegos de coches que incorporan un cuidadísimo motor de simulación física que atiende a doscientos mil parámetros… pero sólo en el coche del jugador y en los tres o cuatro vehículos rivales que se dibujan en pantalla. El escenario y sus elementos son estáticos, simplemente están ahí colocados.

Rompemos paredes de forma más o menos realista al dispararles con nuestra "shotgun" en cualquier FPS pero… ¿son trozos reales que se comportan de manera física al caer al suelo o se trata de animaciones rígidas pre calculadas que se activan? Y el agua, ¿cuando podremos disfrutar de simulaciones de océanos realistas de una forma natural?

Evidentemente con la potencia y las herramientas actuales no podemos ni soñar con representar un mundo interactivo, tridimensional y con un motor de físicas realistas aplicado a todos sus objetos. El futuro ya tiene otra roca en el camino que destrozar.

nVidia ya trabaja en ello con sistemas de partición de meshes capaces de reventar una malla tridimensional en pedacitos y que cada uno se convierta en un objeto físico. Y claro, hablamos de miles de pedazos calculándose en tiempo real.

Epic, con su Unreal Engine 4, se ha fijado también en las partículas y prometen atmósferas y sistemas de partículas realistas y que atiendan a la gravedad, a las fuerzas que se les aplican o a respetar las formas físicas que tienen delante de ellos. Chispas que saltan y rebotan en paredes o estructuras cercanas y cuyo rebote se calcula en tiempo real, nubes de polvo cuya densidad y comportamiento ante una corriente de aire podrá regularse ajustando sus parámetros…

El mundo que nos rodea está lleno de partículas de infinitos tamaños y nos hemos acostumbrado a vivir con ellas. El mundo 3D va en camino de hacer lo mismo.

De cuando una textura de difuso era suficiente

Hubo una época en la que un polígono envuelto en una textura de difuso era suficiente para dejarnos con la boca abierta. Recuerdo cómo me alucinaba 'Oni' en su momento y viéndolo ahora uno se da cuenta de lo mucho que ha cambiado todo.

Llevamos años intentando representar gráficos de la manera más realista posible y se han hecho muchos avances en la materia. Pero no todo se trata de polígonos como veíamos antes. La animación y la texturización son puntos clave de lo que se nos viene encima. Centrémonos pues en todo el juego que nos dan las texturas.

La generación actual de consolas ha supuesto un gran avance en este campo. PlayStation 2, por poner un ejemplo, supuso un gran salto en cuanto a gestión de polígonos pero no en cuanto a capacidad para almacenar texturas. Los personajes más detallados de esa época sólo mostraban mapas de difuso (vamos, la textura a pelo puesta sobre la geometría mediante su canal de mapeo) y de lightmap (la iluminación pre calculada que se hace textura y se aplica sobre la geometría en otro canal diferente al de difuso).

PS3 y Xbox 360 (aunque creo que en cierta medida y con limitaciones lógicas la Cube y la Xbox original también tuvieron juegos que los utilizaban) añadieron el "normal mapping" para dar una falsa sensación de relieve a la textura, el "specular"para darle brillos y recrear superficies metálicas o muy pulidas y el control de"specular por textura" para definir mediante un shader y una imagen en blanco y negro qué zonas de un modelo 3D reciben más brillo y qué zonas menos.

¿Recordáis los primeros juegos de PS3 y Xbox 360 en los que todos los personajes brillaban como muñecos de cera? Todavía no habían implementado el control de "specular" por textura. Los juegos actuales ya no adolecen de lo mismo.

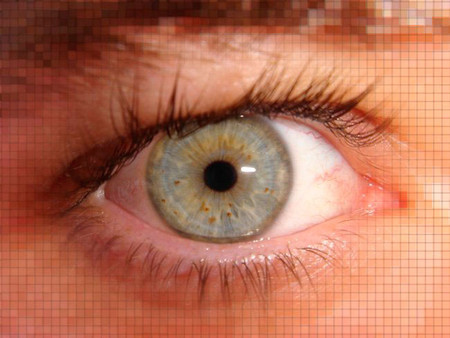

El futuro pasa por seguir avanzando en la misma línea y conseguir representar todo tipo de materiales de una forma muy realista. En el 3D CGI se consigue pero, ¿y el que se tiene que mover en tiempo real? Sinceramente creo que la piel va a ser el principal fuerte a conquistar de esta generación.

Conseguir una piel realista es algo en lo que muchas compañías ya están trabajando. nVidia, Activision, Quantic Dreams y por extensión Sony… no sólo se trata de llegar a un tono realista, se trata de que parezca piel.

Con todas sus imperfecciones, con las arrugas que se forman, con las acumulaciones de sangre bajo la epidermis que le confieren a determinadas zonas un aspecto más rojizo, la peculiar forma en la que absorbe la luz… en definitiva, hay trabajo por hacer y uno de los más complicados pasa por la piel.

Tu boca dice no pero tus ojos dicen sí

¿Podermos cruzar durante esta generación y de una vez por todas el maldito "uncanny valley"? Yo me la juego y apuesto a que no. Tenemos demasiados frentes abiertos como para pensar en que una representación 3D puede colar como real.

Estamos dando pasos decididos en esa dirección, eso sí, pero todavía faltan muchos cabos sueltos. Hemos visto que ya puede no ser una cuestión de polígonos y que posiblemente el asunto de las texturas se consiga solucionar… entonces, ¿qué nos queda por superar? Entre otras cosas la animación.

El ser humano es una máquina salvaje de generar micro movimientos y reacciones inesperadas. La animación de personajes, por definición, es todo lo contrario. Un animador debe calcular y pensar exactamente qué va a hacer su personaje para representar una determinada actitud, un sentimiento… incluso una pretendida animación brusca de reacción espontánea no es más que el resultado final de un montón de pruebas hasta llegar a una que parece ser espontánea sin serlo en absoluto.

Tenemos herramientas y sistemas para calcar la animación humana, el "acting" de personajes y hemos dado pasos de gigante para que los protagonistas principales de los videojuegos se muevan con soltura y naturalidad… pero estamos a años luz de conseguir que parezcan reales. Lo parecen, sí, si los comparamos con los protagonistas de videojuegos de hace 10 años.

Pero la gran piedra en el camino se llama animación facial. Hace años a un personaje principal de videojuego le pedíamos que corriera, apuntara e incluso muriera de una forma molona. Hoy les pedimos sentimientos. Queremos verlos sufrir, queremos que se enamoren… queremos un comportamiento más adulto propio de las grandes historias que ahora nos cuentan.

Y para eso necesitamos expresividad. No sólo en la manera de moverse, el llamado "acting", también en la cara. Complejos riggins faciales y estupendos animadores dedicados capaces de tener más de cincuenta huesos en la cara del personaje para captar micromovimientos y expresiones. Pero aún y así no es suficiente.

Se están desarrollando nuevas tecnologías que escanean y copian las animaciones faciales de los actores y las trasladan a complejos modelos 3D al estilo de lo que se viene haciendo hace años con la animación corporal. Funciona relativamente, 'L.A. Noire' fue un ejemplo claro de cómo avanzar en esa dirección, pero hasta ahora encontrábamos un escollo insalvable. El cuerpo se animaba por un lado. La cara por otro.

Y el ser humano es la suma de las dos cosas siempre así que de nuevo volvíamos a caer en el sufrido animador profesional que debía ser capaz de sacar toda su habilidad para unir las dos líneas de animación de una manera lógica. En Quantic Dreams, especialistas en este tipo de situaciones por el estilo de juegos que desarrollan, han empezado a jugar con una nueva tecnología que permite captar a la vez las dos animaciones.

Se graba al actor realizando movimientos corporales mientras se está captando al mismo tiempo su expresión facial. Queda margen de mejora, está claro, pero la nueva generación de ahondar en esta dirección.

No lo veas a través de una ventana. Entra y disfruta

Pero independientemente de cómo evolucionen los motores gráficos o de si conseguimos romper el valle inquietante o nos rompe él a nosotros hay una tendencia clara que ayudará a unificar todas esas posibilidades en una sola experiencia. La inmersión.

Nintendo dio un paso decidido al llevar la Wii al mercado de consumo masivo. Ya no le asusta a nadie que un juego pueda controlarse agitando un mando y una parte del futuro que se nos viene encima camina en esa misma dirección.

Experiencias que intentan sumergirnos mucho más en el videojuego pero que, de momento, no han acabado de funcionar todo lo bien que se esperaba. Kinect y PlayStation Move no dejan de ser productos marginales de los que no hacen uso la mayoría de grandes lanzamientos. Y en esas que llega una vieja idea, ochentena y noventera si me apuráis que todos dábamos por perdida pero que vuelve a coger fuerza, los cascos de realidad virtual.

John Carmack, Gabe Newell, Cliff Bleszinski y muchos otros pesos pesados de la industria se alinean junto a productos como Oculus Rift. Unas gafas VR diseñadas para llevarnos al centro mismo de la acción en un videojuego, para que estemos allí.

Un ángulo de visión de 110 grados, giroscopios encargados de detectar fielmente el movimiento de nuestra cabeza y adaptar lo que vemos en pantalla, profundidad 3D a dos centímetros de los ojos para que la sensación sea lo más bestia posible… los que han probado este "headset" surgido de las bondades de kickstarter y apoyado ya por innumerables "business angels" aseguran que es la experiencia VR más bestia que se ha hecho jamás.

Pero, ¿realmente el futuro pasa por ahí? ¿acabaremos comprando cascos de realidad virtual para disfrutar de determinados videojuegos o es un camino sin salida? Hace poco Nolan Bushnell aseguraba que efectivamente, tanto Oculus Rift como Google Glass son el auténtico futuro. Quizá esa tecnología pueda mezclarse con las bondades de Kinect o incluso de un sencillo Wii Mote para que seamos partícipes de las experiencias más inmersivas jamás realizadas.

Las piedras del camino en la nueva generación

Romper el valle inquietante consiguiendo modelos 3D que parezcan reales y cuyas texturas tengan las mismas imperfecciones y características que las del mundo real. Personajes que se muevan como lo hacemos nosotros, con ese porcentaje de aleatoriedad y cierto punto impredecible que por ahora se escapa a la animación de videojuegos, que expresen emociones y en cuyos rostros podamos intuir el paso del tiempo o incluso las secuelas de un duro día de trabajo.

Un mundo físico que se comporte como el nuestro y cuyos elementos tengan peso, se sientan atraídos por la gravedad y se puedan romper en pedazos. Un mundo en el que la luz incide en el polvo ambiente y el polvo ambiente se dispersa a nuestro alrededor según las corrientes de aire que producimos al pasar. Suena a quimera y posiblemente no lleguemos a verlo cumplido en la próxima generación pero seguro que es Ítaca para los pioneros que deben conseguir las herramientas de software y el hardware que lo haga posible.

Y al final de todo, cuando todos esos escollos se hayan podido sortear quedará saber si para nuestros hijos será algo normal el colocarse cascos de realidad virtual para disfrutar de un modo que a día de hoy parece propio de películas de ciencia ficción.

Es el futuro, pero nunca había estado tan cerca.